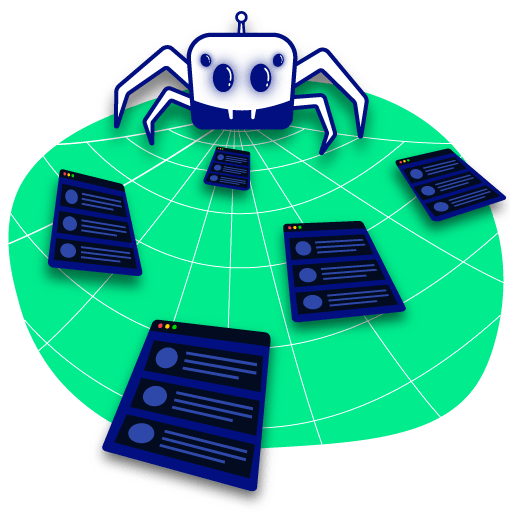

Apa itu web crawler?

Web crawler, atau bot mesin telusur mengunduh dan mengindeks konten dari seluruh Internet. Tujuan bot semacam itu adalah untuk mempelajari (hampir) setiap halaman web di web, sehingga informasi dapat diambil saat dibutuhkan. Mereka disebut “perayap web” karena perayapan adalah istilah teknis untuk mengakses situs web secara otomatis dan memperoleh data melalui program perangkat lunak.

Bot ini hampir selalu dioperasikan oleh mesin pencari. Dengan menerapkan algoritme penelusuran ke data yang dikumpulkan oleh web crawler, mesin telusur dapat menyediakan tautan yang relevan sebagai tanggapan atas kueri penelusuran pengguna, menghasilkan daftar laman web yang muncul setelah pengguna mengetik penelusuran ke Google atau Bing (atau mesin telusur lainnya) .

Bot web crawler seperti seseorang yang membaca semua buku di perpustakaan yang tidak teratur dan menyusun katalog kartu sehingga siapa pun yang mengunjungi perpustakaan dapat dengan cepat dan mudah menemukan informasi yang mereka butuhkan. Untuk membantu mengkategorikan dan menyortir buku-buku perpustakaan berdasarkan topik, penyelenggara akan membaca judul, ringkasan, dan beberapa teks internal dari setiap buku untuk mengetahui isinya.

Fungsi Web Crawler

Web crawler adalah sebuah tool yang berfungsi untuk melakukan crawling dan indexing. Nah, jika IAR tidak mengindeks website Anda, maka website Anda tidak akan muncul di hasil pencarian. Jika situs web bahkan tidak muncul di hasil pencarian, tidak mungkin untuk mendapatkan posisi teratas dalam hasil pencarian.

Bagaimana cara kerja web crawlers?

Internet terus berubah dan berkembang. Karena tidak mungkin untuk mengetahui berapa banyak halaman web total yang ada di Internet, bot perayap web mulai dari benih, atau daftar URL yang dikenal. Mereka merayapi halaman web di URL tersebut terlebih dahulu. Saat mereka merayapi halaman web tersebut, mereka akan menemukan hyperlink ke URL lain, dan mereka menambahkannya ke daftar halaman untuk dirayapi berikutnya.

Mengingat banyaknya halaman web di Internet yang dapat diindeks untuk pencarian, proses ini dapat berlangsung hampir tanpa batas. Namun, perayap web akan mengikuti kebijakan tertentu yang membuatnya lebih selektif tentang halaman mana yang akan dirayapi, dalam urutan apa untuk merayapinya, dan seberapa sering mereka harus merayapinya lagi untuk memeriksa pembaruan konten.

Kepentingan relatif dari setiap halaman web: Sebagian besar perayap web tidak merayapi seluruh Internet yang tersedia untuk umum dan tidak dimaksudkan untuk; alih-alih mereka memutuskan halaman mana yang akan dirayapi terlebih dahulu berdasarkan jumlah halaman lain yang tertaut ke halaman tersebut, jumlah pengunjung yang didapat halaman tersebut, dan faktor lain yang menandakan kemungkinan halaman tersebut berisi informasi penting.

Idenya adalah bahwa halaman web yang dikutip oleh banyak halaman web lain dan mendapatkan banyak pengunjung cenderung berisi informasi otoritatif berkualitas tinggi, jadi sangat penting bahwa mesin pencari mengindeksnya seperti yang mungkin dilakukan oleh perpustakaan pastikan untuk menyimpan banyak salinan buku yang diperiksa oleh banyak orang.

Mengunjungi kembali halaman web: Konten di Web terus diperbarui, dihapus, atau dipindahkan ke lokasi baru. Perayap web secara berkala perlu mengunjungi kembali halaman untuk memastikan versi konten terbaru diindeks.

Persyaratan robots.txt: crawling web juga memutuskan halaman mana yang akan dirayapi berdasarkan protokol robots.txt (juga dikenal sebagai protokol pengecualian robot). Sebelum merayapi laman web, mereka akan memeriksa file robots.txt yang dihosting oleh server web laman itu. File robots.txt adalah file teks yang menentukan aturan untuk bot apa pun yang mengakses situs web atau aplikasi yang dihosting. Aturan ini menentukan halaman mana yang bisa dirayapi bot, dan tautan mana yang bisa mereka ikuti.

Semua faktor ini memiliki bobot yang berbeda dalam algoritme kepemilikan yang dibuat oleh setiap mesin telusur ke dalam bot laba-laba mereka. Perayap web dari mesin telusur yang berbeda akan berperilaku sedikit berbeda, meskipun tujuan akhirnya sama: mengunduh dan mengindeks konten dari laman web.

Leave a Reply